・Mistral AIが最新のオープンモデル「Mixtral 8x22B」を発表。AIコミュニティに新たな基準を打ち立てる高効率モデル。

Mixtral 8x22Bは多言語対応、高い数学・コーディング能力を有し、大規模アプリ開発を可能にする。Apache 2.0ライセンス下で公開。

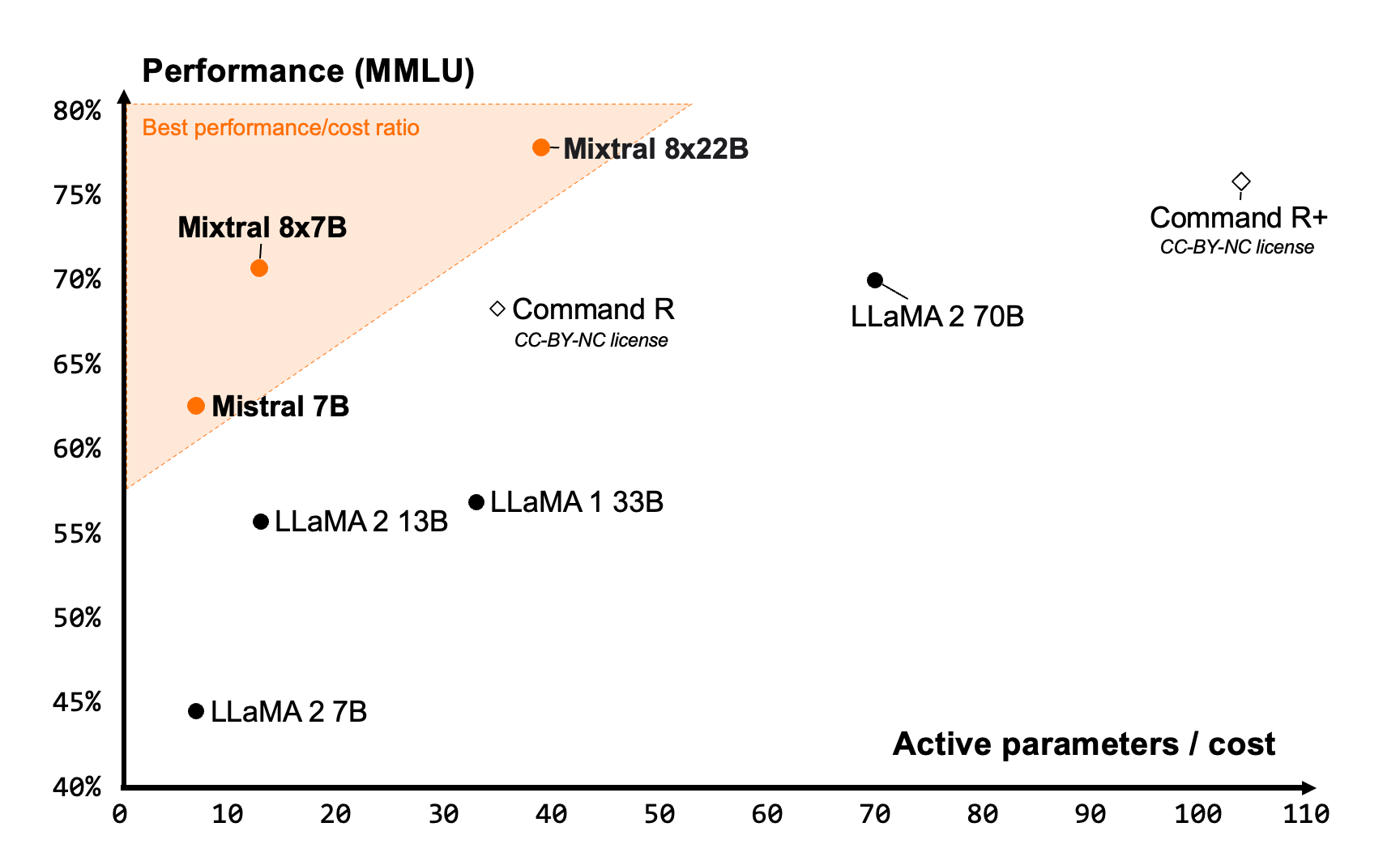

業界標準ベンチマークで他のオープンモデルを上回る性能を示す。La Plateforme上で試用可能。

Mistral AIは、最新のオープンモデル「Mixtral 8x22B」を発表しました。このモデルは、AIコミュニティにおいて、パフォーマンスと効率性の新たな基準を打ち立てるものです。Mixtral 8x22Bは、1410億のパラメータのうち390億の活性パラメータのみを使用するスパースなMixture-of-Experts (SMoE) モデルであり、そのサイズにおいて比類のないコスト効率を実現しています。

Mixtral 8x22Bの特長

- 英語、フランス語、イタリア語、ドイツ語、スペイン語に対応

- 高い数学と コーディング 能力を保有

- ネイティブに関数呼び出しが可能で、la Plateforme上で実装された制約付き出力モードと合わせて、大規模なアプリケーション開発とテックスタックの近代化を可能にする

- 64Kトークンのコンテキストウィンドウにより、大量のドキュメントから正確な情報を想起可能

真のオープンモデル

Mistral AIは、AIにおけるイノベーションとコラボレーションを促進するために、オープン性と幅広い普及の力を信じています。そのため、最も許容範囲の広いオープンソースライセンスであるApache 2.0の下で、Mixtral 8x22Bを公開し、誰でも制限なくどこでもモデルを使用できるようにしています。

最高の効率性

Mistral AIは、それぞれのサイズにおいて比類のないコスト効率を提供し、コミュニティが提供するモデルの中で最高のパフォーマンス対コスト比を実現するモデルを構築しています。Mixtral 8x22Bは、オープンモデルファミリーの自然な延長線上にあります。そのスパースな活性化パターンにより、密な70Bモデルよりも高速でありながら、他のオープンウェイトモデルよりも高い性能を発揮します。

業界標準のベンチマークにおけるオープンモデルの比較では、Mixtral 8x22Bが推論、多言語対応、数学、コーディングのタスクで他のオープンモデルを上回る性能を示しています。本日リリースされたMixtral 8x22Bの指示付きバージョンは、さらに優れた数学の性能を示しており、GSM8K maj@8で90.8%、Math maj@4で44.6%のスコアを記録しています。